AI存储-两全其美 为生成式 AI 工具提供性能和规模

发布时间:

2023-02-01 00:00

实现 AI 工作负载的系统性能和规模存在挑战:要实现其中一项比较容易,但要实现这两个指标却很难。

进入2023年,我们可以越来越清楚地看到 AI 和 AI 驱动的产品和服务正在快速成为主流。对于生成式 AI 工具(比如 ChatGPT, Dall-E 及其他)的极大兴趣已经把 AI 驱动的计算工作推到了聚光灯下。

因此,人们对于 AI 产生了浓厚的新兴趣。组织希望利用生成式 AI 工具现在所展示的各种惊人功能,这些功能可以通过当今的技术来实现。然而在这个过程中,许多组织遇到了一些熟悉的问题,这些问题 AI 专家在多年前已经认识到:让正确组合的计算资源、存储系统和数据集以高产、效率高的方式协同工作很难。这也是为什么 DDN 提供《AI 成功指南》来帮助 AI 新手应对这些挑战。

并行文件系统和存储设备是影响 AI 工作负载的关键问题之一。但是,要真正实现数据科学家和商业专业人士希望的生成式 AI 结果,不仅需要克服基础的限制,还要优化以获得最佳可能方案。

当前,这意味着设计算法和系统不仅要满足最新 AI 模型的性能需求,还要能扩展以处理模型所需的巨大数据集。实现现代 AI 工作负载的高级性能和规模是一项富于挑战性的任务,当然,有一些基础设施配置可以使其成为可能。

首先,我们要理解这些系统如何运作的基本原理,以及为什么许多现有的硬件和软件部件不是特别适合那些需求。AI 算法背后的基本思想涉及两个关键步骤,它们可以被认为是模式识别和模式匹配。步骤一,在模式识别阶段,一组大型标注数据(即人类已经定义了它是什么)被输入到一个数学模型,该模型计算这些数据具有什么独特特征 – 这个过程被称为“训练模型”。然后,这些学习到的特征被代码化到算法中。步骤二,在模式匹配阶段,一组未标注的数据由这个刚更新的算法进行处理并找出具备类似于步骤一所发现特征的数据,步骤二被称为推理。

大部分新一代的 AI 工作都是由 Transformer 或基础模型支持的。尽管它们与其他基于 AI 的算法有点相似:都是基于机器学习的神经网络,根据输入需求产生输出结果;它们与众不同之处在于:它们有能力通过一个称为“注意力”或“自我注意力”的数学过程来学习它们正在做的事情的背景和意义。从根本上说,这意味着无需事先由人类对每个用于模型训练的数据点进行标注,算法能够开始自行生成一些上下文。因此,训练过程可以更快,也可能更详尽。需要明确的是,这不是真正的“智能”和对自己在做什么的意识,但如果做得好,它可以非常像人类 - 因此像 ChatGPT 这样的东西具有令人印象深刻的功能。

为了完成所有这些数学工作,你的硬件系统需要具备很高的计算能力并且快速访问海量数据。特别是大语言模型对性能非常敏感,因为要支持实时对话,大量计算需要在运行中完成。在计算方面,高性能 GPU 持续发展和改进以满足这些 AI 模型不断增长的需求。此外,我们也看到许多公司(包括传统芯片厂商和云公司)引入了专用的 AI 加速器。类似于 GPU,这些新型 AI 加速器专门设计来同时进行大量计算 – 这是苛刻算法的关键要求。DDN 公司的 A3I 是能保证 GPU 超过99.9% 利用率的存储系统 – 保证 GPU数据饱和意味着在更短的时间内有更多的输出。

与高计算能力同样重要的是快速访问海量数据。与传统工作负载由服务器 CPU 提供支持不同,这些以 AI 为中心的工作负载和运行这些负载的专用芯片对存储系统提出了截然不同的要求。例如,现有的企业存储系统可以处理很大的文件或数据集,但是它们受限于单通道串行连接到内存。另一方面,因为 AI 算法的计算类型,它们通常需要多通道连接来并行地传输数据到 GPU 和 AI 加速器内的不同计算引擎。

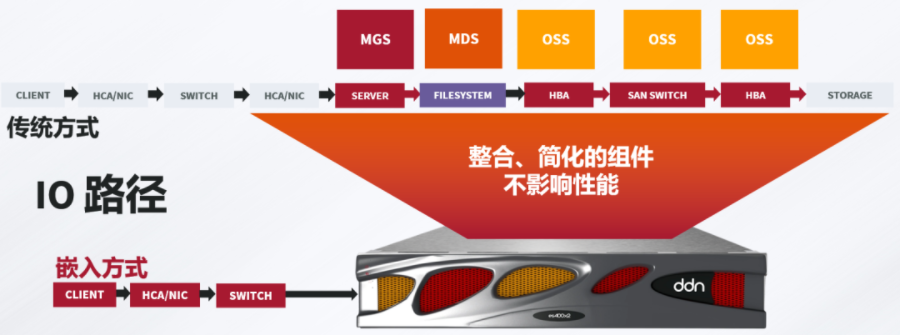

另一个挑战是传统大型存储系统使用的网络文件系统(如NFS)只是设计来串行传输数据的 – 部分原因是以 CPU 为中心的服务器系统的工作方式。为了快速响应数据的同时请求,存储系统内需要并行文件系统和硬件控制器。为了应对这个问题,DDN 公司的存储设备内置了 EXAScaler 并行文件系统(基于开源的 Lustre 文件系统开发),并把所有关键元件集成到一个简单的机架安装式设备中。这种做法不仅可以在单个计算系统与存储之间实现性能优化的连接,还为扩展这些连接打下了基础。当更多的计算节点和存储设备被连接在一起时, 这种类型的连接支持更高的并行吞吐量和更好的容量扩展。而且,为了更好地利用高性能 GPU,DDN 存储系统还支持 GPUDirect Storage ( GDS ) 技术。GDS 支持从存储到位于 GPU 上的高带宽内存的直接路径,这使 GPU 的潜能得到利用并提高在此过程中的性能。

ChatGPT 和其他可能还会推出的生成式 AI 工具正在激发人们对许多领域的 AI 应用的新兴趣。正如这些令人激动的工具所展示的,适当调试 AI 算法和运行它们的系统能够实现令人印象深刻的功能,引发公众的想象。搭建这种系统以提供满足新算法所需的性能和规模并不总是那么简单。然而,通过适当的规划和正确的数据优先策略(包括AI 存储)很有可能实现,并且它们带来的潜力也非常有吸引力。

#人工智能 #AI存储 #ChatGPT #并行文件系统

了解更多关于AI存储:https://www.ddnstorage.com.cn/product_ai.html

【往期推荐】

2. NVIDIA新一代Eos超级计算机和OVX SuperPOD使用DDN存储

相关新闻

暂无数据